EN PT/BR

Criando uma Política de Tecnologia Centrada na Comunidade

Trabalho nos EUA criando políticas de tecnologia centradas na comunidade na União Americana pelas Liberdades Civis de Washington (American Civil Liberties Union of Washington – ACLU-WA). Estou aqui para compartilhar minhas experiências trabalhando com elaboração de políticas nos EUA e também para aprender sobre uma elaboração política mais ampla do que as vozes no Norte Global.

Primeiramente, gostaria de fornecer um breve contexto sobre o que a ACLU faz e sobre o que fazemos no nosso trabalho sobre tecnologia e liberdade. A ACLU é uma organização sem fins lucrativos e o maior escritório de advocacia de interesses públicos nos EUA. Trabalhamos nos tribunais, nas legislaturas e em comunidades para defender e preservar os direitos individuais e as liberdades garantidas a todos nos EUA por meio da nossa constituição e nossas leis. Trabalhamos em diversas áreas de assuntos interseccionais, abarcando assistência médica, imigração, tecnologia, justiça de gênero e cuidados reprodutivos. Nosso objetivo geral, ao realizar nosso trabalho em tecnologia e liberdade, é proteger e fazer avançar as liberdades civis das pessoas e seus direitos protegidos constitucionalmente diante de tecnologias verdadeiramente transformadoras. Focamos em priorizar as vozes de comunidades historicamente impactadas e também em defender essas comunidades para que tenham real poder de decisão, para escolher se as tecnologias serão utilizadas e de que forma. Fazemos isso de quatro maneiras-chave:

– Defendendo novas políticas e leis para criar garantias acerca das tecnologias, ou deter o uso delas completamente;

– Litigando onde as leis existentes são injustas e trabalhando com nossa equipe jurídica para remediar os danos;

– Organizando com as comunidades e aqueles historicamente impactados pelas tecnologias a centrarem em vozes impactadas no impulsionamento para mudanças;

– Engajando em ativismo corporativo, de onde apoiamos o trabalho de ativistas tecnólogos, dentro e fora das empresas.

Focarei a discussão de hoje na construção de políticas de tecnologia centradas na comunidade e começarei por fornecer um pouco de contexto sobre tecnologia, valores e poder. Depois, vou apresentar três estudos de caso: Coalizão para a Equidade Tecnológica (Tech Equity Coalition), o Decreto de Vigilância de Seattle (Seattle Surveillance Ordinance) e projetos de capacitação comunitária.

Tecnologia, valores e poder

A tecnologia é frequentemente apresentada como a solução para muitos dos problemas do mundo, com o pressuposto de que mais tecnologia fará a vida de todos melhor, e não pior. E a tecnologia realmente parece benéfica em muitos sentidos – faz tudo mais rápido, mais barato e mais interconectado. Mas a questão-chave que precisamos nos perguntar é: fazer tudo mais rápido, mais barato e mais interconectado é fazer tudo “melhor”? E, se a resposta for sim, para quem torna tudo melhor?

Cartum de P.S. Mueller.

Fonte: P.S. Mueller

Essa é uma questão importante sobre a qual se pensar, pois, muito parecido com qualquer coisa concebida por humanos, a tecnologia não é “neutra”. Toda tecnologia reflete um conjunto de escolhas de valores feitas por pessoas, e frequentemente pessoas em posições de privilégio e poder. Você pode ver isso não somente no modo como projetamos tecnologia, mas também no modo como projetamos tudo à nossa volta. Na Figura 2, temos exemplos de arquitetura hostil, onde você pode ver objetos pontudos instalados em degraus na França, bem como bancos arco-íris com barras de ferro no Canadá. O desenho deles funciona para impedir aqueles em situação de rua de estarem em lugares públicos. Há uma motivação na maneira como essas ferramentas são construídas, e, do mesmo modo, há uma motivação no modo como a tecnologia tem sido construída, pois humanos que possuem diferentes valores, preconceitos e motivações as constroem.

Arquitetura hostil: objetos pontudos instalados em degraus na França e um banco com separadores no Canadá.

Fonte: Wikipedia, DocteurCosmos / CC BY-SA 3.0, Twitter @isaacazuelos

Precisamos compreender que toda tecnologia é lançada em um contexto de iniquidade estrutural. Aqui estão duas definições de iniquidade estrutural, que descrevem um sistema de privilégios criado por instituições para favorecer algumas pessoas em detrimento de outras:

Iniquidade estrutural: dispositivos pessoais, interpessoais, institucionais e sistêmicos que criam diferenças sistemáticas nas oportunidades que grupos têm, levando a diferenças injustas e evitáveis em seus desfechos.

Outra definição: “Iniquidade estrutural é um sistema de privilégios criado por instituições dentro de uma economia. Essas instituições incluem a lei, práticas de negócios e políticas governamentais. Elas também incluem educação, assistência médica e a mídia.” (Kimberly Amadeo)

Há uma longa história da tecnologia impactando diferentes pessoas de maneiras diferentes. O que aprendi através da história é que toda vez que uma nova tecnologia foi construída, ela teve impactos desproporcionais naqueles mais marginalizados socialmente, quer a tecnologia tivesse a intenção de fazê-lo ou não.

Em 1713, a cidade de Nova York aprovou a Lei da Lanterna, exigindo que pessoas negras e indígenas iluminassem seus rostos à noite, o que encorajava cidadãos brancos a impor sistemas de escravidão e encarceramento. Velas eram a tecnologia da época.

Nos anos 1930 e 1940, o governo dos EUA contratou os serviços da IBM, que fornecia suas máquinas de perfuração de cartão de ponto Hollerith para vigiar e marcar nipo-americanos via dados censitários. Os nipo-americanos foram vigiados e colocados em listas de detenção por quase uma década antes de serem inconstitucionalmente encarcerados durante a Segunda Guerra Mundial. Além disso, as mesmas máquinas Hollerith de perfuração de cartão da IBM seriam usadas por volta da mesma época por nazistas alemães para identificar judeus e outras minorias étnicas, religiosas, políticas e sexuais.

Membros da família Mochida aguardando o ônibus de evacuação. Chapas de identificação eram usadas para auxiliar a manter a unidade familiar intacta durante a evacuação.

Fonte: Dorothea Lange / U.S. National Archives and Records Administration

Nos anos 1950 e 1960, o FBI vigiava líderes dos movimentos pelos direitos civis negros, incluindo Martin Luther King Jr., via grampos e fotos tiradas por informantes. O COINTELPRO (Counterintelligence Program – Programa de Contrainteligência) visava líderes dos direitos civis e do Partido dos Panteras Negras e tentava “neutralizá-los” por meio de assassinatos, prisão, humilhação pública e falsas acusações criminais.

A “carta de suicídio” que o FBI enviou anonimamente a Martin Luther King Jr., em uma tentativa de convencê-lo a cometer suicídio.

Fonte: FBI, Public Domain.

Nos anos 2000, depois do 11 de Setembro, o Departamento de Polícia de Nova York conduziu programas de investigação ilegais mirando por décadas a comunidade islâmica. Após 2002, a Divisão de Inteligência do Departamento de Polícia de Nova York dedicou-se a investigar perfis a partir da religião e a vigiar muçulmanos sem qualquer suspeita em Nova York – ainda que o programa tenha sido barrado por ser inconstitucional.

E, hoje em dia, vemos o Serviço de Imigração e Controle de Aduanas dos EUA utilizando tecnologias poderosas, incluindo leitores automáticos de placas de carros, dispositivos de espionagem de celulares e reconhecimento facial, com o objetivo de deportar imigrantes.

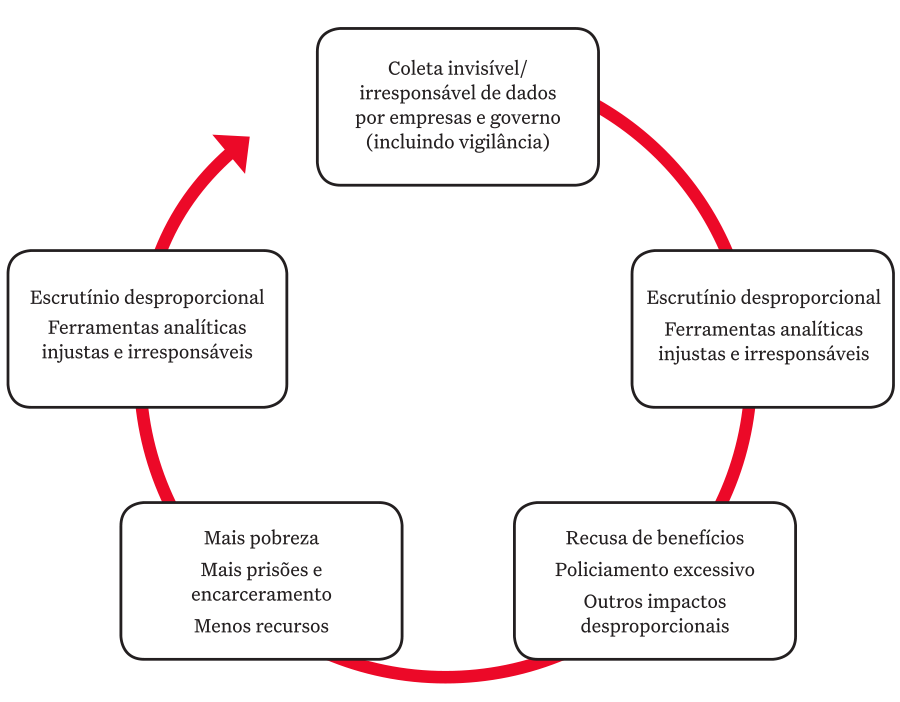

Este diagrama demonstra um ciclo de segmentação da tecnologia em que tecnologias não construídas para as comunidades, que são invisíveis e alheias a elas, causam um escrutínio desproporcional destas, o que leva a danos tangíveis, e esses danos criam mais escrutínio desproporcional.

Ciclo de direcionamento da tecnologia.

Comunidades não estão na mesa de tomada de decisões.

No decorrer dos últimos anos, observamos um crescimento do movimento multissetorial para criar tecnologias e políticas de tecnologias centradas na comunidade, movimento este composto por grupos que incluem comunidades impactadas, como Coalizão para a Equidade Tecnológica, Mijente, Athena (específica para a Amazon), trabalhadores de tecnologia, ativistas das mudanças climáticas e movimentos antitruste.

Em Seattle, construímos o que chamamos de Coalizão para a Equidade Tecnológica, composta por organizações que representam comunidades historicamente marginalizadas que têm sido impactadas pela vigilância, tais como imigrantes, minorias religiosas e pessoas de cor. Esse grupo muito diverso de pessoas trabalha para impulsionar a tecnologia, a fim de que esta seja mais responsável com eles.

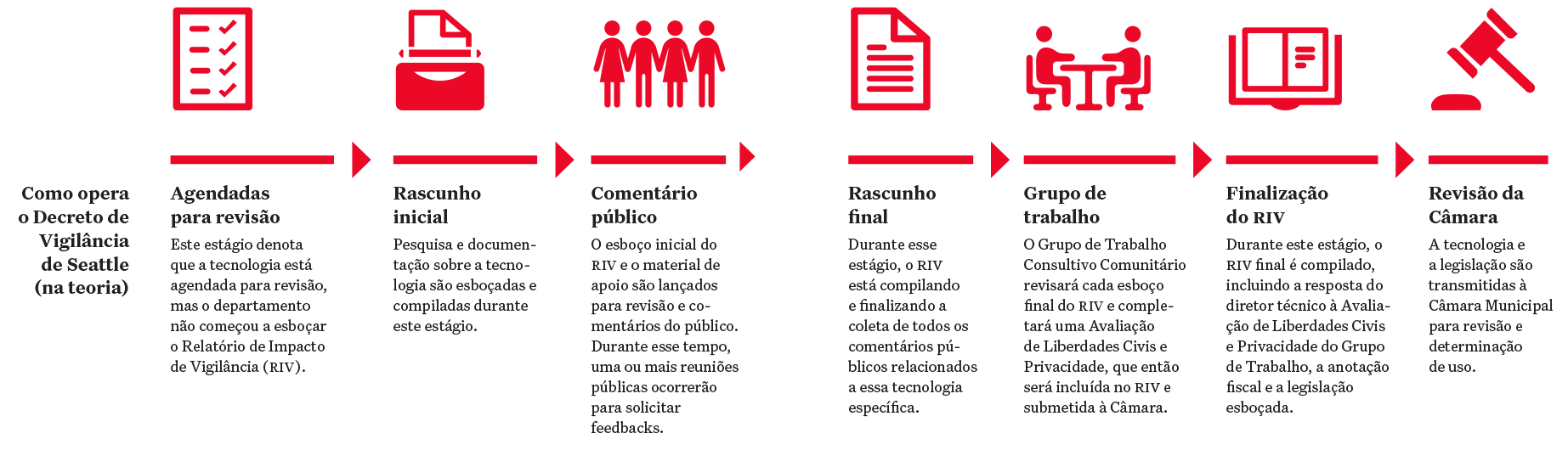

Uma parte-chave deste trabalho da Coalizão para a Equidade Tecnológica tem sido defender e implementar leis de vigilância, como o Decreto de Vigilância de Seattle. Essa é uma lei inédita nos EUA, que trata sobre requerer supervisão pública para o uso de tecnologias de vigilância pelo governo. Esta lei foi aprovada pela primeira vez em 2013, mas sofria de uma definição excessivamente ampla de tecnologia de vigilância, isenções exageradas e um fraco mecanismo de aplicação que não responsabilizava as agências pelo cumprimento da lei. A lei foi alterada em 2017 e 2018 para retificar esses problemas e criar um grupo de trabalho consultivo focado na comunidade, encarregado de fornecer avaliações do impacto das diferentes tecnologias sobre a privacidade e as liberdades civis.

Essa lei pretendia ser um veículo para permitir que as comunidades influenciem diretamente as tecnologias de vigilância, em vez de estas tecnologias acontecerem contra elas. O Decreto de Vigilância de Seattle é um veículo não somente para o engajamento da comunidade e sua capacitação, mas também para educação e engajamento dos legisladores com as comunidades.

No diagrama da página seguinte temos um pequeno pano-rama de como a lei opera na teoria: toda agência utilizando tecnologia de vigilância em Seattle deve escrever um Relatório de Impacto de Vigilância (RIV) detalhando como a tecnologia é usada e apresentá-la ao público. O público então tem a oportunidade de comentar essa tecnologia. Esses comentários públicos são compilados, e o Grupo de Trabalho Consultivo Comunitário tem a oportunidade de revisar esses comentários e fazer recomendações finais à Câmara Municipal, visto que são os legisladores que decidem quais leis são aprovadas em Seattle.

Atualmente, estamos no processo de implementação e já revisamos pouco mais da metade das tecnologias na lista principal. Algumas das tecnologias que revisamos incluem o sistema Coplogic e o Reconhecimento Automático de Placas de Carro (Automated License Plate Reader System – ALPR), do Departamento de Polícia de Seattle, bem como o sistema de sensor Acyclica do Departamento de Transporte de Seattle. Tivemos muitos sucessos e desafios.

Um sucesso do Decreto tem sido nossa habilidade de aprender muitas informações novas sobre tecnologias de vigilância em uso nas agências governamentais. Tivemos a chance de observar quais tecnologias existem e de avaliar as implicações de seu uso na privacidade e nas liberdades civis. Esta transparência é parte integral da construção da responsabilidade. Uma das tecnologias sobre as quais aprendemos muito é a Acyclica, um sensor utilizado pelo Departamento de Transportes de Seattle. Por exemplo, notamos que o Departamento de Transporte de Seattle não tratou de importantes questões sobre o Acyclica no Relatório de Impacto de Vigilância, como interrogações em torno da propriedade e retenção de dados.

Mas um desafio é que até agora não houve uma oportunidade de realmente dizer “não” a uma tecnologia, mesmo que sejamos capazes de fornecer recomendações.

Além do mais, transparência não é responsabilidade, e temos tido que lidar com toda a logística de engajamento em torno do Decreto, incluindo recursos comunitários limitados, políticos não cooperativos, tecnologias e relatórios complicados e um processo bastante lento.

Um outro exemplo de trabalho com o qual a Coalizão para a Equidade Tecnológica tem se engajado são as leis de abrangência estadual, como um projeto de lei de vigilância facial, que é uma lei estadual de Washington que estamos atualmente a impulsionar. No ano passado ajudamos a introduzir essa lei na nossa legislatura, como um esforço para frear o uso de tecnologias de reconhecimento facial racialmente enviesadas, imprecisas e profundamente falhas. Nosso objetivo é fornecer às comunidades impactadas a real chance de dizer “não” – decidir se, e não somente como, a tecnologia deveria ser usada.

Para fazer esse trabalho de construir poder dentro das comunidades para advogar por políticas de tecnologia que são cabíveis a elas, colaboramos em projetos de capacitação comunitária com a Coalizão para a Equidade Tecnológica. Esses projetos são destinados a complementar o conhecimento existente que comunidades impactadas já têm a oferecer, pois, conforme salientei anteriormente, a tecnologia sempre impactou essas comunidades.

Projetos de capacitação comunitária

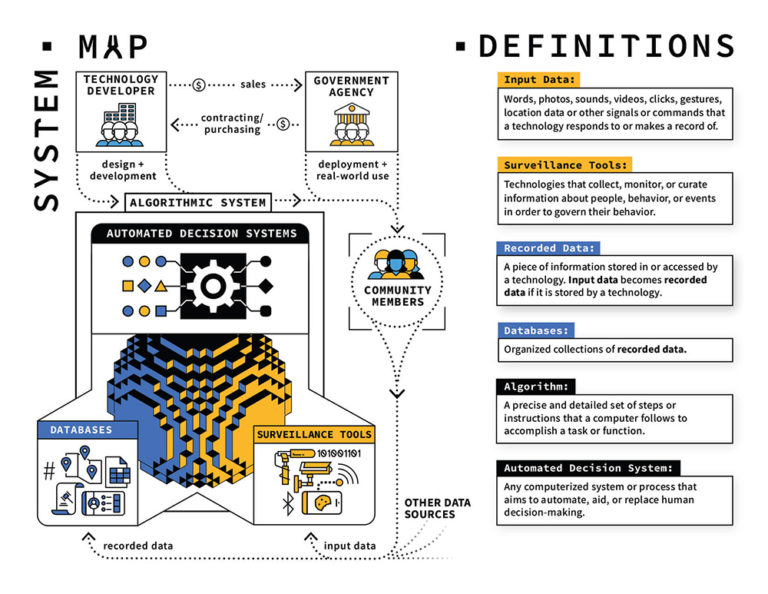

O primeiro projeto de capacitação comunitária é o Algorithmic Equity Toolkit [Kit de ferramentas de equidade algorítmica], que procura auxiliar pessoas a identificarem facilmente e fazerem importantes perguntas sobre sistemas de decisão baseados em inteligência artificial. Colaboramos com o Critical Platform Studies Group [Grupo de estudos críticos de plataforma] para construir uma versão inicial do kit de ferramentas.

Um componente do Algorithmic Equity Toolkit [Kit de ferramentas de equidade algorítmica].

Fonte: Algorithmic Equity Toolkit, disponível em: https://aekit.pubpub.org/

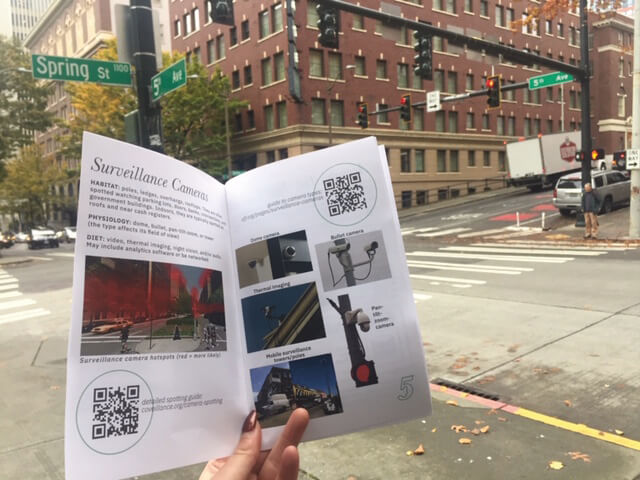

O segundo projeto de capacitação comunitária é um conjunto de ferramentas de oficina de contravigilância no qual estamos colaborando com o coletivo coveillance. Um kit de ferramentas de oficinas de contravigilância foi projetado para ajudar as comunidades a hospedarem suas próprias oficinas e disseminarem informações sobre o ecossistema de vigilância mais amplo. Organizamos duas oficinas-piloto no outono passado e estamos trabalhando com membros da Coalizão para a Equidade Tecnológica para continuar esses pilotos.

Um guia de campo para encontrar tecnologias de vigilância de uma oficina-piloto que aconteceu em Seattle, Washington, EUA.

Fonte: The coveillance collective’s “Field Guide to Spotting Surveillance Infrastructure”, disponível em: https://coveillance.org

Portanto, com esse breve panorama sobre o trabalho que estamos fazendo em Washington para construir políticas de tecnologia centradas na comunidade, vou deixá-los com algumas conclusões:

– As comunidades são realmente as que estão melhor posicionadas para identificar e definir os problemas para a tecnologia resolver;

– As comunidades estão bem conscientes dos impactos das tecnologias, mesmo que não estejam usando linguagem técnica para descrevê-las;

– As histórias de vida e experiências são muito valiosas, e não são apenas valiosas quando você as rotula como dados comunitários;

– As organizações e membros comunitários estão dispostos e ansiosos para liderar.

E vou deixá-los com mais algumas questões-chave para ponderar. Não “essa essa tecnologia é boa ou má?”, mas:

– Para qual propósito estamos construindo essa tecnologia, e com quais regras e valores?

– Quem será impactado? Eles estão nesta sala? Quais outras estruturas de colaboração podemos criar?

– Quem pode dizer “não”?

– Benéfico para quem? Quem define o que é benéfico?

Por fim, minha uma última questão: o que significaria para aqueles com menos poder em conversas sobre tecnologia terem muito mais, ou ainda, terem o maior poder de conceito e implementação no futuro?