EN PT/BR

A mediação jornalística x a mediação algorítmica

As plataformas estão cada vez mais presentes na nossa rotina. Mas será que conseguimos entender e visualizar as várias implicações da inserção desses agentes e da sua lógica de funcionamento nos diversos setores sociais?

Um dos setores que tem sido amplamente influenciado pela lógica das plataformas é o da imprensa. Neste trabalho, proponho pensarmos especificamente sobre as implicações da inserção da mediação algorítmica, que é a base de funcionamento de plataformas de mídia digital, na mediação jornalística. Para isso, apresento dois casos de exclusão de conteúdos feitos pelo Facebook em 2016. Ambos referem-se à exclusão de imagens que não atendiam às normas da plataforma e, por isso, foram retirados de circulação. Como essas exclusões podem nos ajudar a pensar sobre a interferência da mediação algorítmica na circulação de conteúdos?

“Plataformização” descreve o processo de imbricamento das lógicas da plataforma na lógica dos setores sociais, em um processo de moldagem mútua (Van Dijck et al., 2018). No caso do jornalismo, o Facebook se oferece como infraestrutura para o fazer profissional, prometendo soluções para os problemas enfrentados na área, mas exige ajustes e contrapartidas nas práticas e nas lógicas operacionais das instituições (Plantin et al., 2018).

As grandes plataformas digitais, como as Big Five,1 organizam e disponibilizam dados e informações para o funcionamento e a viabilização de empresas de vários setores (Van Dijck et al., 2018). Nesse processo, alcançam escalas enormes, colocando à mostra e até suplantando antigas infraestruturas ao reconfigurar e transformar os processos empresariais nesse movimento (Plantin et al., 2018). Elas se mesclam às infraestruturas anteriores e fazem com que as empresas tenham que ajustar suas estruturas legais e produtivas às suas lógicas de funcionamento.

Plataformas são as provedoras dos softwares e hardwares, e dos serviços que ajudam a codificar as atividades sociais em arquiteturas computacionais. De acordo com Van Dijck (2013), “elas processam (meta)dados através de algoritmos e protocolos formatados antes de apresentarem sua lógica interpretada na forma de interfaces amigáveis com configurações padrão que refletem as escolhas estratégicas do proprietário da plataforma” (p.29, tradução minha).

Ao delegar várias das escolhas realizadas em suas ambiências aos algoritmos, as plataformas inauguram uma nova lógica de conhecimento (Gillespie, 2018a). Isso porque a lógica de seleção

algorítmica difere da lógica editorial – realizada por jornalistas. Enquanto as escolhas jornalísticas se baseiam em escolhas de especialistas, de profissionais capacitados para a sua realização, a

seleção algorítmica “depende das escolhas procedimentalizadas de uma máquina, projetadas por operadores humanos para automatizar alguma representação do julgamento humano ou desenterrar padrões através de traços sociais coletados” (Gillespie, 2018b,

p. 117). Isso se dá porque as “plataformas são máquinas intrincadas de visibilidade gerenciadas por algoritmos (…). Elas permitem a visibilidade e a organizam, não apenas através de políticas, mas

pelo design” (Gillespie, 2018b, tradução minha).

Por isso, discutir as implicações da mediação algorítmica na mediação jornalística significa discutir as implicações da inserção da lógica das plataformas no setor de jornalismo. Para uma definição mais operacional dos algoritmos, recorremos a Introna (2016), que explica que os algoritmos expressam “a solução computacional em termos de condições lógicas (conhecimento sobre o problema) e estruturas de controle (estratégias para resolver o problema), levando à seguinte definição: algoritmos = lógica + controle (Kowalski, 1979)” (p.21, tradução minha).

Vale ressaltar que parto do entendimento de que o jornalismo é uma instituição social importante para o desenvolvimento da democracia porque auxilia os cidadãos a se informarem sobre acontecimentos globais e locais. Além disso, entendo que a ação de “mediar” (Latour, 2012) necessariamente transforma o conteúdo mediado, tomando mediação enquanto sinônimo de ação. Ou seja, acredito que, quando um agente participa de um processo de mediação, ele necessariamente interfere, age e influencia o processo em questão.

Quando olhamos para o processo de circulação de informações jornalísticas nas plataformas digitais, vemos a inserção de várias novas camadas de mediação, além daquelas realizadas pelos jornalistas. O problema é que geralmente essas camadas são invisibilizadas pelas plataformas que insistem em se apresentar enquanto “intermediárias” e facilitadoras, ou seja, como agentes que não

interferem nos processos. Para Gillespie (2018a), isso acontece porque a apresentação de um algoritmo como imparcial “o certifica como um ator sociotécnico confiável, concede relevância e credibilidade aos seus resultados e mantém a aparente neutralidade do provedor em face às milhões de avaliações que faz” (p. 107).

Na Figura 1 tentamos exemplificar algumas das várias camadas de mediação que influenciam o acesso às informações nas plataformas de mídia digital. Nesse caso, vemos a interface do Facebook – o feed de notícias do usuário – em um acesso por smartphone.

Exemplo das camadas de mediação no acesso ao Facebook.

Fonte: Amanda Jurno

Contudo, assim como qualquer mediação, aquelas realizadas pelas plataformas também influenciam os processos. Por exemplo, não podemos ignorar a dimensão humana dos algoritmos e das plataformas digitais (Diakopoulos, 2014), porque a própria delimitação dos seus critérios de base, passo essencial para o seu funcionamento, implica uma visão limitada dos significados e reproduz as subjetividades dos humanos que os criaram. Segundo O’Neil (2017), modelos matemáticos como os algoritmos do Facebook nunca são objetivos e sempre carregam a subjetividade e os vieses dos seus programadores: “Modelos são opiniões embutidas em matemática. (…) Em cada caso, nós devemos perguntar não só quem desenhou o modelo, mas também o que aquela pessoa ou companhia está buscando alcançar” (p.21, tradução minha).

E o que busca o Facebook quando define os critérios dos algoritmos do feed de notícias? De acordo com a plataforma, o feed busca “apresentar as histórias mais importantes para você, toda vez que

abrir o Facebook”,2 mas não explica o que considera “importante” nem como isso é feito. De acordo com informações oficiais, os posts são valorados a partir de uma série de critérios, como data de publicação, proximidade entre quem publicou e quem vai ler, engajamento, tipo de mídia, dentre outros ( Jurno, 2016). Depois de valorados, eles são distribuídos e organizados para serem exibidos aos usuários. Mas, como toda seleção implica exclusão, se alguns posts são escolhidos para serem exibidos, significa que vários outros não são.

Os posts escolhidos têm o objetivo de manter os usuários na plataforma por mais tempo, uma vez que o modelo de negócios do Facebook se baseia na venda de anúncios personalizados. Portanto,

quanto mais tempo os usuários passarem na plataforma, mais eles serão expostos a anúncios, e mais dados serão gerados, que poderão ser usados para otimizar a personalização desses anúncios. E é por isso que a plataforma se preocupa tanto em mostrar aos usuários o que eles querem ver – para que eles não saiam dali.

Mas, apesar de ser uma plataforma presente na vida das pessoas há algum tempo, ainda é grande o número de usuários que afirma não saber como ela funciona: a maioria deles, de acordo com pesquisa realizada pelo Pew Research Center (Smith, 2018). De forma geral, 53% dos usuários do Facebook afirmam “não saber nada” ou “não muito” sobre como os posts são incluídos nos seus feeds de notícias, e só 14% afirma saber “bastante”. Apesar de o percentual ser maior entre usuários mais velhos, 41% dos usuários de 18-29 anos e 50% de 30-49 afirmam não entender o funcionamento de tal seleção. Ou seja, não se trata de um problema geracional.

O desconhecimento do funcionamento e dos critérios de (in)visibilidade de conteúdos no Facebook se torna um problema quando os usuários acessam a plataforma para se informar sobre notícias e conteúdos jornalísticos. Se esses conteúdos jornalísticos que são exibidos para os usuários são diretamente influenciados pela lógica de funcionamento da plataforma e dos seus algoritmos, significa necessariamente que os conteúdos não selecionados pelos algoritmos para serem exibidos acabarão invisibilizados. E quais as implicações dessa invisibilização?

Edição da história e invisilibidade dos invisíveis

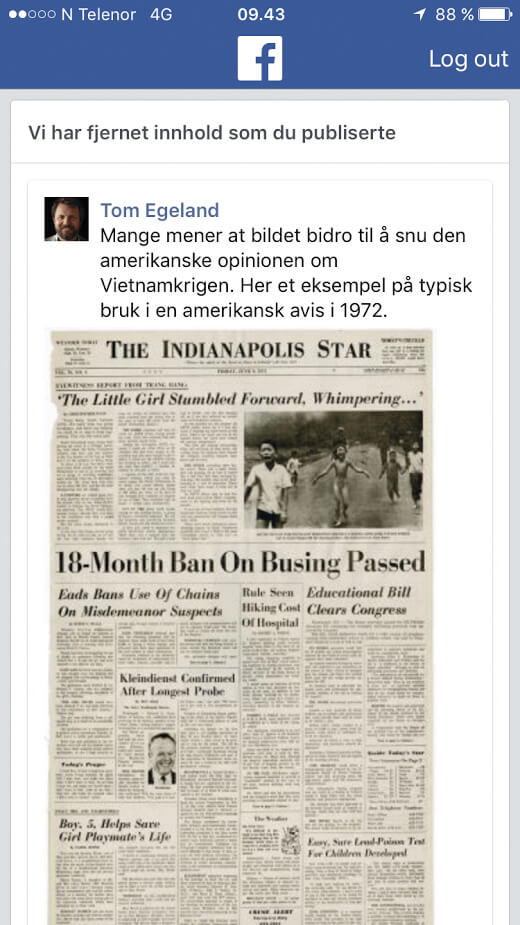

Em agosto de 2016, o escritor e jornalista norueguês Tom Egeland postou um conjunto de imagens de guerra no seu perfil no Facebook, com o objetivo de debater o uso de fotografias icônicas no jornalismo, especificamente imagens fortes em contextos de guerras e conflitos que tiveram importante papel no desenrolar de eventos históricos (Egeland, 2019). Egeland postou sete imagens, mas no dia seguinte percebeu que uma delas havia sido deletada pelo Facebook: a famosa

foto TheTerror of War [O terror da guerra]. De acordo com mensagem da plataforma, a fotografia tinha sido excluída porque violava as políticas sobre nudez, conteúdo sexual e pornografia infantil do Facebook.

A fotografia deletada, também conhecida como Napalm’s Girl [A garota do Napalm], foi tirada por Nick Ut na Guerra do Vietnã em 1972. A imagem retrata um grupo de crianças fugindo

de um ataque a bomba, tendo assim papel central na conscientização da população civil estadunidense à época sobre os horrores da guerra que se desenrolava naquele país, e sobre a qual o governo mantinha confidencialidade.

A fotografia The Terror of War.

Fonte: Nick Ut

Egeland se disse abalado e surpreso com a exclusão, porque “a imagem em si é icônica e mundialmente famosa e não existe sexualidade nela. É apenas uma foto de uma vítima de guerra, por isso, se esse é um exemplo de nudez, é muito estúpido” (Koren e Wallenius, 2016). Mas a imagem seguiu sendo excluída todas as vezes em que foi publicada, inclusive quando estampada na capa de um jornal da década de 1970.

Print da tela de Tom Egeland com a informação de que sua publicação havia sido removida.

Como Tom Egeland é um conhecido autor e jornalista norueguês, o caso rapidamente ganhou espaço na mídia jornalística local. A exclusão gerou uma onda nacional de protestos, e vários profissionais, veículos jornalísticos e usuários também publicaram a imagem em seus perfis.

Todos tiveram o conteúdo excluído e alguns foram banidos da plataforma. Espen Hansen, editor-chefe de um grande jornal norueguês, o Aftenposten, afirmou que a exclusão não era sobre “nudez”, mas uma questão de liberdade de expressão, história e guerra (Stenerud, 2016).

Em reação à exclusão, o jornal publicou uma carta aberta ao CEO do Facebook, em que Hansen (2016) afirmou que Zuckerberg era “o editor mais poderoso do mundo” e que estava abusando do seu poder e prejudicando a criação de uma sociedade democrática. Em entrevista ao jornal The Guardian, um porta-voz do Facebook afirmou: “Embora reconheçamos que essa foto é icônica, é difícil criar uma distinção entre permitir uma fotografia de uma criança nua em uma instância e não em outras” (Hansen, 2016). A repercussão do caso envolveu até a primeira-ministra norueguesa Erna Solberg, para quem a atitude da plataforma era “altamente lamentável” e a remoção das

imagens significava “editar nossa história comum” (Wong, 2016).

Essa exclusão nos leva a pensar que, em um mundo onde o Facebook é fonte de informações, tal imagem jamais teria circulado amplamente e nunca chegaria a desempenhar o papel que teve no

movimento antiguerra estadunidense na década de 1970. Em setembro, vinte dias após o início da controvérsia, a plataforma decidiu reconsiderar o caso e permitir a circulação da imagem. Via

porta-voz, afirmou que após ouvir a “comunidade” reconheceu “a história e importância global desta imagem em documentar um momento particular no tempo” (Heath, 2016). Para Solberg

(2016), “apagar posts contendo tais imagens é limitar a liberdade de expressão, a democracia, o direito de criticar e de questionar, e de ver os eventos passados como eles realmente eram, não como eles foram considerados por uma corporação gigante”.

Nenhuma das explicações dadas pela plataforma trouxe informações sobre a seleção dos conteúdos ou a definição dos critérios dos algoritmos. Em resposta à ministra, a chefe de operações do Facebook, Sheryl Sandberg, reiterou a importância de manter a nudez fora da plataforma e descreveu tais decisões como sendo “difíceis”: “Nós nem sempre acertamos. Mesmo com padrões claros, filtrar milhões de postagens caso a caso a cada semana é um desafio” (Solberg, 2016). O gerente de comunicações do Facebook nos países nórdicos, Peter Münster, afirmou: “É importante lembrar que o Facebook é uma comunidade global e devemos ter um conjunto de regras que se aplicam a qualquer padrão cultural. Isso não é perfeito, mas é difícil fazê-lo de maneira diferente ao gerenciar uma comunidade global” (Reuters, 2016).

Mas que “comunidade global” é essa a que o Facebook se refere? Será ela mesmo global ou apenas um reflexo dos pensamentos estadunidenses? Ou ainda, um reflexo de um grupo muito específico

de pessoas que vivem no Vale do Silício e compartilham os mesmos valores? E o que significa usar como base para a seleção de conteúdos padrões tão específicos, referentes a uma visão de mundo

localizada, para filtrar conteúdos globalmente?

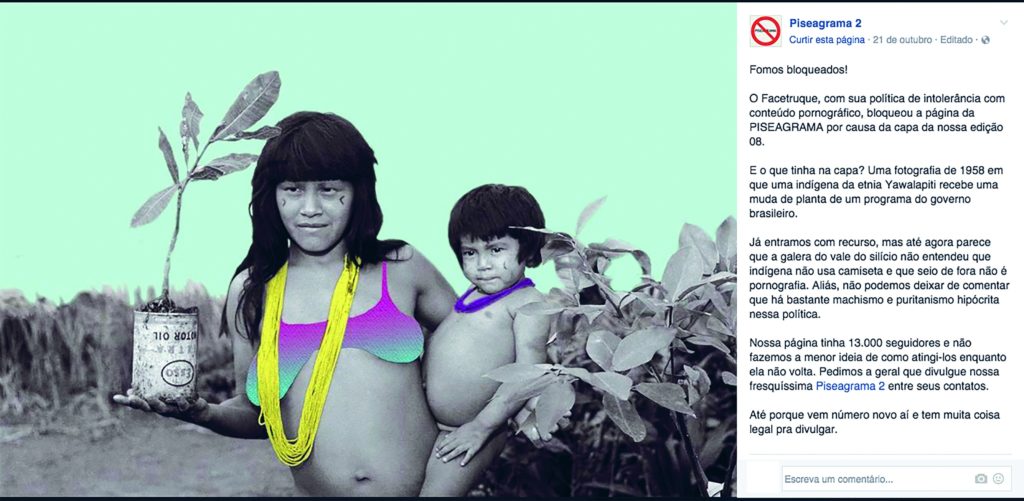

O segundo exemplo aconteceu em outubro de 2016, quando o Facebook deletou um post da revista Piseagrama que continha a fotografia de uma índia Yawalapiti amazônica com seios nus. A fotografia foi tirada em 1958 durante campanha de reflorestamento realizada pelo governo militar brasileiro e servia de ilustração para a matéria de capa da nova edição. Porém, como a plataforma não permite a publicação de mamilos femininos (salvo casos de amamentação, e após muitas controvérsias), tal imagem foi deletada. Mas não só a imagem, como também a página da revista Piseagrama no Facebook foi excluída, fazendo com que o veículo perdesse seu conteúdo e sua rede de leitores e seguidores. Após a criação de uma nova página, os editores republicaram a fotografia colocando um sutiã na mulher indígena retratada.

Segundo post com a imagem da mulher indígena, agora com um sutiã adicionado digitalmente para atender aos padrões de moderação do Facebook.

Restrita aos seguidores da página, a repercussão não foi suficiente para reverter a censura, e a plataforma nunca respondeu aos administradores. No post em que publicaram a nova imagem, os

editores da Piseagrama comentaram a exclusão: “Parece que a galera do Vale do Silício não entendeu que indígena não usa camiseta e que seio de fora não é pornografia. Aliás, não podemos deixar de comentar que há bastante machismo e puritanismo hipócrita nessa política” (Piseagrama 2, 2016).

Vale destacar que essa não foi a primeira vez que o Facebook invisibilizou imagens de indígenas. Por exemplo, em abril de 2015, o Ministério da Cultura foi alvo de censura da plataforma por causa de uma fotografia tirada em 1909 por Walter Garbe. A imagem, que retratava um casal de índios Botocudos – ambos com os seios desnudos –, havia sido publicada às vésperas do Dia do Índio para divulgação do lançamento do Portal Brasiliana Fotográfica. À época, o então ministro da Cultura, Juca Ferreira, afirmou que o bloqueio da imagem pelo Facebook mostrava como a plataforma “tenta impor ao Brasil, e às demais nações do mundo onde a empresa opera, seus próprios padrões morais, agindo de forma ilegal e arbitrária. (…) O Facebook e outras empresas globais operam numa lógica muito próxima à dos tempos coloniais”. Após o desbloqueio da imagem, o Facebook afirmou que “não é fácil encontrar o equilíbrio ideal entre permitir que as pessoas se expressem criativamente e manter uma experiência confortável para a nossa comunidade global e culturalmente diversa” (Zero Hora, 2015).

Esses dois exemplos nos mostram como a mediação algorítmica influencia na circulação dos conteúdos jornalísticos. Contudo, uma das imagens continuou invisível para os usuários do Facebook. Quando é a lógica algorítmica que determina o que será visualizado (ou não) pelos usuários, conteúdos que não atendem aos critérios da plataforma simplesmente são excluídos (ou invisibilizados), ainda que isso signifique editar a história comum ou invisibilizar indivíduos que já são amplamente invisibilizados na nossa sociedade.

A difícil tarefa de editar

Em vários momentos, o Facebook recorre ao argumento de que é “difícil” editar e definir quais imagens podem circular ou não na plataforma. Sabemos que não é fácil. Inclusive, a decisão de publicar a fotografia de Nick Ut foi difícil mesmo na década de 1970, porque trata-se de uma imagem forte que viola os direitos de privacidade das crianças retratadas. Porém, com base em normas e valores profissionais jornalísticos, levando em consideração as várias nuances e singularidades da imagem e do momento histórico, questões subjetivas e circunstanciais, os editores e jornalistas decidiram que a publicação da fotografia era importante e decidiram fazê-la com todos os riscos envolvidos.

A profissão do jornalista é exercida com base em uma série de normas e padrões, compartilhados pelo grupo de pessoas que se reconhecem enquanto profissionais, que visa preparar o profissional

para tomar decisões “difíceis” como essas. Mas quando uma plataforma, como o Facebook, se apresenta como infraestrutura para a circulação do conteúdo jornalístico, ela adiciona várias camadas de mediação à mediação dos profissionais capacitados para realizar a seleção de conteúdo. Nesse processo, independentemente da escolha dos editores e jornalistas, é a mediação algorítmica que realmente vai definir se a imagem vai circular ou não.

Como já discutimos anteriormente, os critérios em que os algoritmos se baseiam para tomar suas decisões visam aumentar o tempo gasto pelo usuário na plataforma, muitas vezes se valendo da

capacidade de tal conteúdo gerar engajamento. Preocupantemente, esses também são os critérios que favorecem, ou mesmo encorajam, a circulação de conteúdos de desinformação, sensacionalistas, e que geram fortes emoções nas pessoas (Wardle, 2017). Além disso, devemos lembrar que a natureza dos algoritmos impossibilita-os de lidar com singularidades e particularidades que são tão importantes na seleção jornalística, como as que apresentamos neste texto.

Sabemos que o Facebook é uma fonte importante de informação ao redor do mundo. E ainda que as pessoas não usem o Facebook para encontrar notícias, elas acabam usando outras plataformas

que também têm a seleção algorítmica como base de funcionamento, como Google, Instagram, Twitter, entre outras.

Então, como podemos lidar com essa situação? Como nós, pessoas interessadas em entender e construir tecnologias melhores, podemos pensar em uma maneira pela qual a seleção algorítmica

não seja tão prejudicial à circulação de notícias e informações confiáveis? Com a crescente quantidade de conteúdo que circula online, todos os dias, é impossível pensar em uma solução que não inclua seleção algorítmica. Se essa lógica da seleção é contrária aos valores do jornalismo, e se a base da seleção algorítmica é categorizar e padronizar o conteúdo, como podemos construir novas tecnologias que possam reunir essas duas lógicas diferentes e abarcar outras singularidades que escapam a ambas? Ou ainda, como podemos fabricar tecnologias que não prejudiquem o acesso público a fontes de notícias e informações confiáveis, já que os algoritmos inerentemente não lidam com a subjetividade e o conteúdo jornalístico e histórico, o “social” e o “humano” estão cheios de subjetividades?

1 Big Five é um termo usado em referência ao grupo formado pelas principais e maiores plataformas digitais ocidentais – Google, Amazon, Facebook, Microsoft e Apple (Van Dijck et al., 2018).

2 Ver “News Feed,” https://www.facebook.com/formedia/solutions/newsfeed. Acesso em 05 mai. 2020.

REFERÊNCIAS

DIAKOPOULOS, Nicholas. Algorithmic accountability: Journalistic investigation of computational power structures. Digital Journalism, no. 3, pp. 398-415, 2015.

EGELAND, Tom. Email. Comunicação pessoal. Fevereiro de 2019.

GILLESPIE, Tarleton. A relevância dos algoritmos. Tradução de Amanda Jurno. Parágrafo. São Paulo, v. 6, n. 1, pp. 95-121, jan./abr. 2018a.

GILLESPIE, Tarleton. Custodians of the Internet: Platforms, content moderation, and the hidden decisions that shape social media. New Haven: Yale University Press, 2018b

HANSEN, Espen Egil. Dear Mark. I am writing this to inform you that I shall not comply with your requirement to remove this picture. In: Aftenpost. 08 set. 2016. Disponível em: https://www.aftenposten.no/meninger/kommentar/i/G892Q/Dear-Mark-I-am-writing-this-to-inform-you-that-I-shall-not-comply-with-your-requirement-to-remove-this-picture. Acesso em: 09 fev. 2019.

HEATH, Alex. Facebook decides to lift its ban on a controversial Vietnam War photograph. In: Business Insider. 09 set. 2016. Disponível em: https://www.businessinsider.com.au/facebook-lifts-ban-on-napalm-girl-vietnam-war-photo-2016-9. Acesso em: 09 fev. 2019.

INTRONA, Lucas D. Algorithms, governance, and governmentality on governing academic writing. Science, Technology & Human Values, 2016.

JURNO, Amanda Chevtchouk. Agenciamentos coletivos e textualidades em rede no Facebook: uma exploração cartográfica. 2016. (Dissertação – Mestrado em Comunicação). Universidade Federal de Minas Gerais. Belo Horizonte, 2016.

KOREN, Beate A.; WALLENIUS, Hege. Facebook fjernet foto Tom Egeland la ut av krigsoffer. In: VG. 20 ago. 2018. Disponível em: https://www.vg.no/nyheter/i/62R6e/facebook-fjernet-foto-tom-egeland-la-ut-av-krigsoffer. Acesso em: 09 fev. 2019.

LATOUR, Bruno. Reagregando o social: Uma introdução à teoria do ator-rede. Salvador: Edufba, 2012.

O’NEIL, Cathy. Weapons of math destruction: How big data increases inequality and threatens democracy. Broadway Books, 2017.

PISEAGRAMA 2. 21 out. 2016. Post. In: Facebook. Disponível em: https://www.facebook.com/revistapiseagrama/photos/ 1836470833263129. Acesso em: 23 out. 2016.

PLANTIN, Jean-Christophe; et al. Infrastructure studies meet platform studies in the age of Google and Facebook. New Media & Society. 20, no. 1, 2018, pp. 293-310.

REUTERS. Países da União Europeia aprovam leis mais duras contra Google e Facebook. In: O Globo. 15 abr. 2019b. Disponível em: https://oglobo.globo.com/economia/paises-da-uniao-europeia-aprovam-leis-mais-duras-contra-google-facebook-23600649. Acesso em: 19 jul. 2019.

SMITH, Aaron. Many Facebook users don’t understand how the site’s news feed works. In: Pew Research Center. 05 set. 2018. Disponível em: https://www.pewresearch.org/fact-tank/2018/09/05/many-facebook-users-dont-understand-how-the-sites-news-feed-works/. Acesso em: 29 nov. 2020.

SOLBERG, Erna. Facebook had no right to edit history. In: The Guardian. 09 set. 2016. Disponível em: https://www.theguardian.com/commentisfree/2016/sep/09/facebook-napalm-vietnamese-deleted-norway. Acesso em: 09 fev. 2019.

STENERUD, David. The girl in the picture saddened by Facebook’s focus on nudity. In: Dagsavisen. 02 set. 2016. Disponível em: https://www.dagsavisen.no/verden/the-girl-in-the-picture-saddened-by-facebook-s-focus-on-nudity-1.773232. Acesso em: 09 fev. 2019.

VAN DIJCK, José; POELL, Thomas; DE WAAL, Martijn. The platform society: Public values in a connective world. Oxford: Oxford University Press, 2018.

WARDLE, Claire. Fake news. It’s complicated. In: First Draft – Medium. 16 fev. 2017. Disponível em: https://medium.com/1st-draft/fake-news-its-complicated-d0f773766c79. Acesso em: 10 dez. 2019.

WONG, Julia Carrie. Mark Zuckerberg accused of abusing power after Facebook deletes ‘napalm girl’ post. In: The Guardian. 09 set. 2016. Disponível em: https://www.theguardian.com/technology/2016/sep/08/facebook-mark-zuckerberg-napalm-girl-photo-vietnam-war. Acesso em: 09 fev. 2019.

ZEROHORA. 18 abr 2015. Após Ministério da Cultura ameaçar processo, Facebook republica foto censurada. Fotografia de índia com seios expostos foi retirada da rede social. In: Zero Hora. Disponível em: http://zh.clicrbs.com.br/rs/noticias/noticia/2015/04/apos-ministerio-da-cultura-ameacar-processo-facebook-republica-foto-censurada-4743029.html. Acesso em: 27 jun. 2017.