EN PT/BR

Maneiras alternativas de ver-entender algoritmicamente

Como podemos pensar de maneira diferente as formas algorítmicas de ver-entender? Em um mundo em que algoritmos de ver-entender estão se tornando ferramentas militares de vigilância que geralmente não nos servem (exceto talvez para algumas empresas do Vale do Silício e as superpotências militares), como podemos, mesmo que um pouco, quebrar com isto? Escrevo este texto como uma provocação,1 tentando encontrar uma maneira de resolver essas questões que continuam me incomodando… mas também tentando entender como é possível relacionar-me com elas e, talvez, usá-las para orientar minha prática.

Para (tentar) “pensar de maneira diferente”, quero começar desconstruindo a linguagem dessas perguntas. O que chamo de ver-entender é uma tentativa inicial de des-linguagem provocativa do muito hypado campo de “Visão Computacional” (sim, em maiúsculas).

Desde 2009, com a criação de um grande banco de dados chamado ImageNet, o uso do aprendizado de máquina para criar algoritmos de Visão Computacional disparou rapidamente, com resultados que receberam muito interesse acadêmico, comercial e público. O ImageNet foi criado por Fei-Fei Li, professora da Universidade de Stanford, e sua equipe. O que eles criaram, em termos gerais, foi uma enciclopédia visual do mundo dos objetos, onde cada “coisa” na taxonomia é representada por uma coleção de imagens (ver Crawford e Paglen, 2019, para uma análise crítica). O projeto usou a mão de obra de trabalhadores da Amazon Mechanical Turk, uma plataforma global de trabalho extremamente mal pago, para rotular as imagens. Esse banco de dados virou o combustível para criar novos tipos de análise algorítmica, tornando-se um conjunto de dados de treinamento padrão, levando a um enorme crescimento dos aplicativos de Visão Computacional.

Anos depois, em 2015, Fei-Fei Li apresentou um TED Talk amplamente visto, em que ela apresenta sua visão para o ImageNet (Li, 2015). (Adoro essas apresentações de TED Talks, principalmente devido à tentativa um tanto brega de criar uma narrativa convincente e emocional por trás de um tópico.) Durante os quinze minutos de sua bem composta história, ela expôs muitas das motivações e visões de mundo por trás do aprendizado de máquina da Visão Computacional. O ponto crucial dela era que as câmeras podem tirar fotos, mas elas não conseguem entender o que realmente está acontecendo nas imagens. Elas só podem ver o mundo como pixels, ou como Li os chama, “números sem vida”. As imagens não carregam significado dentro de si. Como “ouvir [hear] não é o mesmo que escutar [listen]”, tirar fotos não é a mesma coisa que ver.

Ver, Fei-Fei Li disse, é realmente entender. O que a ImageNet supostamente possibilita que os algoritmos atuais de Visão Computacional façam é entender o que está nas imagens, baseando-se nos padrões criados por meio da análise de grandes quantidades de dados rotulados. Como ela explica, “a visão começa nos olhos mas, de fato, acontece realmente no cérebro”. Entender o mundo, uma ação cognitiva do cérebro, significa usar experiências anteriores para dar sentido a ele. Ao reunir mais e mais dados, ela argumentou, o treinamento de computadores permitiria que os algoritmos entendessem o mundo como nós, seres humanos.

O meu argumento é que reconhecer a Visão Computacional como um processo de ver-entender pode ajudar-nos a repensá-la criticamente, além das atuais perspectivas hegemônicas. Isto serve para sublinhar o fato de que não se trata apenas de ver/sensoriar o mundo. A Visão Computacional, na verdade, está enraizada em um processo epistemológico muito mais profundo e complexo de entender o mundo, fazer escolhas sobre o que ver, o que priorizar, como construir sentido do que está lá. Isso nos lembra que ver é um processo ativo, como já havia sido descrito pelo pintor Henri Matisse, em 1954: “Ver é em si uma operação criativa, exigindo um esforço” (Matisse, 1954). Existem muitas maneiras de ver, assim como muitas maneiras de entender, e elas têm grande importância.

Quero usar um caso do Brasil para elaborar como o entendimento da visão pela tecnologia é uma ação complexa e cheia de camadas. Monteiro e Rajão (2017) estudaram como o sensoriamento remoto desempenha um papel na detecção e no rastreamento do desmatamento na floresta amazônica. Embora haja muitos dados de satélite sendo coletados, todos eles precisam passar pelo escrutínio de cientistas-analistas que descrevem as áreas desmatadas nas imagens. Os dados de satélite, embora possam parecer realmente completos e detalhados, pois provêm de instrumentos de visão realmente caros e precisos, não contam a história completa por si só. Os cientistas-analistas precisam trabalhar intensamente, colocando juntos vários conjuntos de dados, colaborando entre si de diversos campos e localizações, usando seus conhecimentos qualitativos de campo, etc. Esses especialistas interpretam o que veem através das lentes “tecnológicas” do satélite para criar sentido, tanto como cientistas quanto como cidadãos preocupados, para saber se o que estão vendo é desmatamento ou apenas uma nuvem passando. Além disso, eles precisam equilibrar sua interpretação para garantir não serem mal compreendidos pela sociedade e por políticos, que podem ver os resultados finais como exagerados ou imprecisos.2

Olhando para imagens de satélite, os cientistas-analistas estão realmente tentando entender e dar sentido ao mundo, interpretando por meio de múltiplas camadas de análise, conhecimento situado e corporalidade. Suas decisões sobre o que ver têm efeitos diretos no mundo, o que também informa suas maneiras particulares de ver-entender. Em outras palavras, as infraestruturas de informação para monitorar perda florestal operam “na interseção de demandas políticas que se interferem mutuamente, de objetivos incomensuráveis e de lógicas organizacionais concorrentes” (Vurdubakis e Rajão, 2020, p. 18). Embora “a floresta amazônica continue sendo a mais observada do mundo” (Vurdubakis e Rajão, 2020, p. 18), o que se torna visível depende das “formações de rede instáveis” sociotécnicas de tecnologias geoespaciais e humanos.

É claro que essa discussão não é realmente nova. Muitos historiadores e teóricos da visão e de Science, Technology, and Society (STS) [Ciência, tecnologia e sociedade] discutiram o que está por trás do “esforço” da visão. Berger (2008), por exemplo, falou sobre “modos de ver”, dizendo que o processo de ver pinturas, bem como o processo de ver qualquer coisa, é muito menos espontâneo e natural do que costumamos acreditar – dependendo em grande parte dos hábitos e convenções da pessoa que vê. Existem muitos outros que discutem isso, como Crary (1992), para quem o corpo é uma parte intrínseca de nossas maneiras de ver; Parks (2005), para quem o satélite, como descrito anteriormente, pode funcionar como uma maneira de ver que esconde-mostra de maneiras particulares; e Impett (2020), para quem diferentes modelos de visão computacional podem ver a produção artística de maneiras diferentes. O fato é: nem nas pinturas artísticas ou nas visões de satélite do mundo, ou mesmo nos algoritmos da visão computacional, existe uma “visão de lugar nenhum” (Haraway, 1988), uma maneira distante e removida de ver que também não está ligada a uma maneira particular de entender. Ver-entender é um processo ideológico e, sempre que a tecnologia está envolvida, há muito mais camadas a serem consideradas.

Assim, com isso estabelecido, podemos pular para a Visão Computacional de hoje. Os algoritmos mais prevalentes e poderosos de ver-entender em nossa sociedade têm fortes vínculos com a vigilância do consumidor e o militarismo. Ou, como descrito pelo artista e pesquisador Adam Harvey, “as ferramentas de vigilância por visão computacional mais poderosas hoje desenvolvidas vêm do Facebook, Intel, IBM e Google, e são usadas principalmente para rastrear consumidores” (Harvey, 2020). Na lógica do “capitalismo de dados” (West, 2017), as empresas estão usando enormes quantidades de dados coletados para criar previsões personalizadas automatizadas de comportamento em escala: “Cada vez mais direcionadas a ações, sentimentos e desejos individuais, em vez de agregados populacionais estratificados” (Mackenzie, 2013, p. 392). Além da erosão proposital da privacidade na “cultura visual invisível” da visão das máquinas, os usos da tecnologia militar são particularmente preocupantes. Desde a orientação de mísseis até a operação de drones, empresas e exércitos trabalham juntos para criar máquinas de visão perigosas e letais que “vigiam e punem”, frequentemente de maneira automática.

A história diz que “se a única ferramenta que você tem é um martelo, você pode acabar vendo tudo como um prego”. A maneira como os algoritmos hegemônicos de ver-entender trabalham está diretamente ligada à vigilância e ao olhar militar e a suas maneiras econômicas, raciais e sociais de ver-sensoriar-detectar e entender-fazer-sentido-compreender. Assim, do mesmo modo como Katherine Ye, no primeiro capítulo desta publicação, discute como o Vale do Silício cria ferramentas para certas pessoas e por certas pessoas, esses algoritmos de ver e entender estão vendo e compreendendo algumas pessoas, e algumas pessoas/coisas estão sendo vistas e entendidas. Isso, embora possa parecer óbvio, é na verdade um exercício de poder muito ativo no qual precisamos nos centrar em nossa tentativa de pensar em alternativas.

Algoritmos de ver-entender, assim como quaisquer outros algoritmos, não são caixas pretas, mesmo que estejam, sem dúvida, sendo obscurecidos por muitas camadas de sigilo corporativo e linguagens técnicas. Seus modos de ver-entender, e não apenas os usos para os quais estão sendo direcionados, são moldados diretamente por visões e imaginários particulares do que a visão por meio das máquinas é e o que pode fazer. Isso se relaciona com os apelos de Louise Amoore para focar na opacidade dos algoritmos em vez de tentar torná-los “transparentes” ou “éticos” (Amoore, 2020). Ela diz: “Onde as demandas políticas por transparência reafirmam a visão objetiva de um observador desencarnado, ficar com a opacidade é insistir na perspectiva situada, corporificada e parcial de todas as formas de conhecimento científico”. Amoore está apontando exatamente para a necessidade de colocar em primeiro plano como o “entender” está acontecendo e o que é privilegiado, em vez de tentar de alguma maneira acreditar que algum dia alcançaremos uma suposta objetividade algorítmica. Embora eu possa concordar com Fei-Fei Li de que o que realmente importa é compreender as imagens, entendo que existem muitas formas diferentes de ver-entender que podem ser consideradas e/ou privilegiadas, e que isso é crucial para romper com as problemáticas perspectivas hegemônicas.

Assim, podemos concluir, mesmo que provisoriamente, que nossas maneiras de encontrar alternativas podem e devem se concentrar tanto em: 1) experimentar com maneiras de ver e entender diferentes dos imperativos da visão militar e da vigilância por meio da Visão Computacional; e 2) romper com a dinâmica de poder que permeia os algoritmos atuais de Visão Computacional, invertendo/subvertendo as suas relações de poder.

E como isso se daria na prática? Tenho três sugestões que quero apresentar, também provisoriamente, para nos ajudar a começar a imaginar e conjecturar alternativas. Estas não são, repito, abrangentes de tudo que tem sido feito neste campo, mas apenas provocações para a nossa discussão.

1) A necessidade de um olhar desobediente. Como os algoritmos podem inverter o que e quem é visto, e com isto focar na vigilância dos mais poderosos, ao invés dos marginalizados?

Um dos projetos que eu diria avançar nessa direção é o Forensic Architecture, do Reino Unido. Seu objetivo é usar a grande quantidade de dados gerados pelo capitalismo de dados e vigilância, a fim de criar diferentes modos de ver, uma espécie de arquitetura “contraforense” que vigia estados, polícia e exércitos. Mais relacionado à Visão Computacional, um dos projetos deles, o Triple-Chaser, criou um algoritmo que captura imagens da Internet e tenta detectar quais tipos de bombas estão sendo usadas em determinadas regiões do mundo. O objetivo deles é pressionar as empresas que criam essas bombas e responsabilizá-las. Em colaboração direta com este projeto está o VFRAME, projeto de Harvey que oferece mais amplamente ferramentas de visão computacional de código aberto para apoiar e ajudar o trabalho de ativistas e jornalistas que cobrem guerras: “Facilitando o testemunho visual de zonas de conflito ao redor do mundo por meio do uso da visão computacional para navegar em grandes volumes de dados coletados por cidadãos e jornalistas” (Harvey, 2020).

Frame do vídeo do Triple-Chaser, uma investigação do Forensic Architecture

Fonte: Forensic Architecture/Praxis Films, vídeo disponível na íntegra em:

https://forensic-architecture.org/investigation/triple-chaser

Site do VFRAME (https://vframe.io/).

Fonte: VFRAME https://vframe.io/

A ideia de um olhar desobediente também está presente no projeto OpenOversight (2020), que oferece “um banco de dados público e pesquisável de policiais”. Em um país como os EUA, onde a brutalidade policial é um problema grave que afeta especialmente as comunidades marginalizadas, o projeto visa permitir que os cidadãos “identifiquem um policial com quem tiveram uma interação negativa”. A palestra de Eileen McFarland “Watch the Watcher: Facial-Recognition & Police Oversight” [Observe o observador: Reconhecimento facial e supervisão da Polícia] discute como o reconhecimento facial foi alavancado pelo projeto para pré-processar os dados e servir de suporte à classificação de fotos por seres humanos (McFarland, 2019). O reconhecimento facial já está sendo usado por policiais para identificar cidadãos, com consequências muitas vezes terríveis (por exemplo, identificar e punir ativistas). Portanto, em vez de ser a polícia usando algoritmos para facilitar a identificação de pessoas, o projeto dá aos cidadãos o poder de investigar e identificar policiais que possam ter cometido atos violentos contra os cidadãos.

2) A importância de enfrentar os erros, falhas e ineficiências desses sistemas, tanto como um sinal de suas limitações quanto como uma forma de pensar o diferente. Os algoritmos de Visão Computacional, como qualquer algoritmo ou modelo estatístico, são intrinsecamente falhos e devem ser vistos como as ferramentas tendenciosas e imprecisas que são. Precisamos, portanto, usar isso tanto para pensar sobre como poderíamos colocar em primeiro plano sua ineficiência quanto para encontrar alternativas.

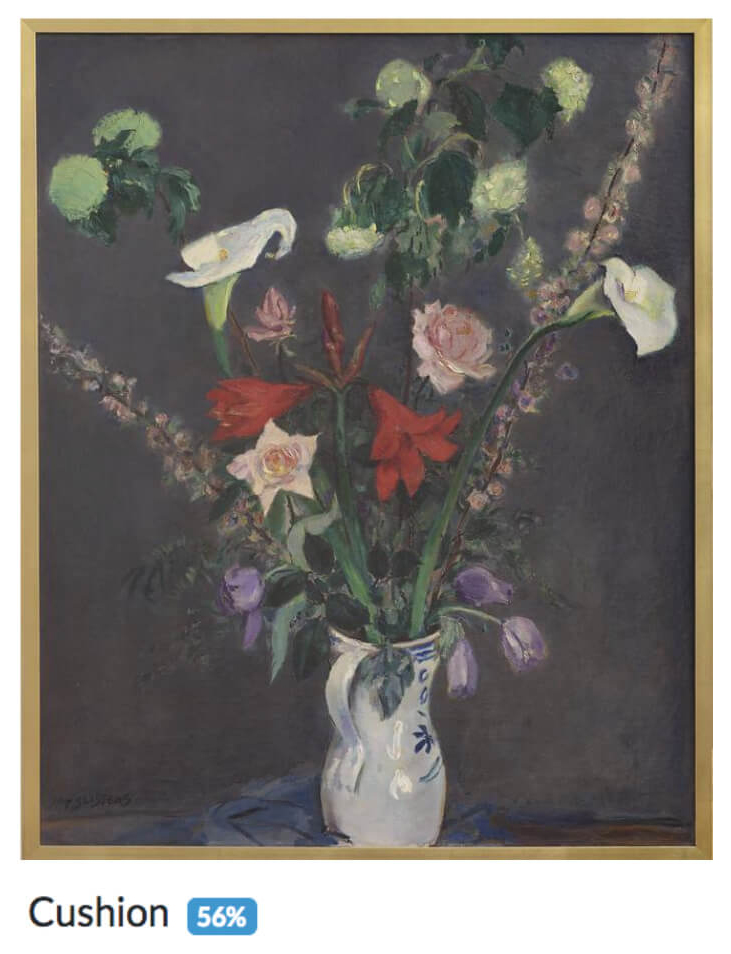

Juntamente com o pesquisador e artista Bruno Moreschi criamos o Recoding Art, em que usamos a Visão Computacional comercial de Google, Amazon, IBM e outras empresas para tentar ver-entender as obras de arte da coleção do Van Abbemuseum, em Eindhoven, na Holanda. Como pode ser visto nas Figuras 3 e 4, pinturas coloridas tendem a ser lidas como almofadas, o que mostra como o olhar maquínico foi especialmente treinado para ver o mundo de forma comercial, como produtos. Isso também nos lembra, por outro lado, como o conteúdo visual das obras de arte ultrapassa os limites do museu e se torna parte dos produtos domésticos populares. Além disso, relaciona-se com as lojas de museu e suas práticas de transformar imagens de obras de arte em souvenirs. Uma vez que esses resultados são transmitidos ao público, eles abrem o museu, questionam as interpretações normativas das obras de arte, e convidam o público a experimentar outras formas de ver: e se a pintura de George Braques for, de fato, uma almofada? O trabalho visa criticar as formas normativas de visão da Visão Computacional, ao mesmo tempo que indica que elas podem ser usadas de maneiras que vão contra suas intenções, resultando em potenciais criativos (Pereira e Moreschi, 2020).

La Roche-guyon (1909), de Georges Braque,

lido pela Visão Computacional como almofada

e decoração de casa.

Fonte: Bruno Moreschi & Gabriel Pereira

Vaas met Bloemen (1929), de Jan Sluijters,

lida pela Visão Computacional como almofada.

Fonte: Bruno Moreschi & Gabriel Pereira

3) Mais do que nunca, considerar: o que devemos nos recusar a construir/criar/desenvolver? Isso significa uma prática que se concentra em especular e/ou agir para desmontar os futuros que não queremos. Isso pode nos ajudar no processo de pensar de maneiras diferentes pois destaca as consequências de modelos perigosos e indica que temos agência sobre a criação de tecnologias (em vez de a tecnologia ter agência por si própria).

No caso do reconhecimento facial, temos visto movimentos fortes em todo o mundo que questionam suas bases centrais. Fight for the Future [Luta pelo futuro], um grupo de artistas, engenheiros, ativistas e tecnólogos dos EUA, liderou um movimento interinstitucional para banir o reconhecimento facial devido ao seu caráter ineficaz, desigual e injusto. É crucial para nós no Brasil também considerarmos isso, especialmente quando esses algoritmos já estão sendo usados em todo o país com resultados terrivelmente racistas: cerca de 90% das prisões provocadas por sistemas de reconhecimento facial eram de pessoas negras (Nunes, 2019).

A resposta aos reconhecimentos faciais pode assumir diferentes formas além de protestos. Uma resposta crítica criativa foram os muitos projetos artísticos desenvolvidos para evitar o reconhecimento facial, como o Facial Weaponization Suite, de Zach Blas, que cria diferentes máscaras amorfas a partir de workshops e agregados de dados de muitas faces (Blas, 2011). Um tipo diferente de resposta é a rejeição direta: movimentos de trabalhadores, como Tech Won’t Build It [A tecnologia não construirá isso], representam a recusa dos trabalhadores em construir ferramentas para uso militar e outros fins nefastos. Os funcionários da Salesforce, em uma carta ao CEO, disseram: “Não podemos ceder à responsabilidade pelo uso da tecnologia que criamos, especialmente quando temos motivos para acreditar que ela está sendo usada para auxiliar práticas tão irreconciliáveis com nossos valores” (Kastrenakes, 2018). Essa retomada do controle inverte as estruturas de poder, retomando a responsabilidade pela criação da tecnologia e dizendo que podemos fazê-lo de uma maneira diferente do que está sendo feito atualmente.

Frame do vídeo “Facial Weaponization Communiqué: Fag Face,” de Zach Blas, com uma das máscaras criadas.

Fonte: Zach Blas (CC BY-NC-ND 3.0), full video available at: https://vimeo.com/57882032

Estas são apenas algumas das maneiras que podemos tentar ver-entender de forma diferente da Visão Computacional atual e hegemônica: olhar desobedientemente e para cima, abraçar os erros e ineficiências, e rejeitar abertamente o que não queremos. Nenhuma dessas direções, entretanto, são soluções em si mesmas. A tarefa de pensar diferente é complicada, pois exige romper com um tanto de coisa que foi intencionalmente tornado normal e inquestionável. Exige criatividade e também luta.

Fei-Fei Li concluiu seu TED Talk dizendo que “pouco a pouco, estamos dando visão às máquinas. Primeiro, nós as ensinamos a ver. Então, elas nos ajudam a ver melhor” (Li, 2015). Minha esperança, em vez disso, é que, pouco a pouco, possamos expandir a forma como as máquinas veem e entendem mais além dos imperativos hegemônicos dos usos de vigilância e militarismo e que, em vez disso, sejamos capazes de usá-las de uma forma mais criativa-justa-equitativa-reflexiva-corporificada-(insira aqui sua palavra), ou… que não as usemos (sempre que isso fizer mais sentido). Minha esperança maior é contribuir para a recusa do determinismo tecnológico e da tecnoutopia, não apenas através da crítica, mas também oferecendo alternativas (mais ou menos concretas).

1 Este texto é uma transcrição aprimorada da minha apresentação no evento Afetando Tecnologias, Maquinando Inteligências (AT/ MI). Agradeço a todas as pessoas que me ajudaram a refletir sobre essas questões em muitas conversas informais, em particular Katherine Ye, Bruno Moreschi, Pablo Velasco e Rodrigo Ochigame.

2 Em um governo que é contra a ideia de que há desmatamento (como o atual governo Bolsonaro, de extrema direta), a maneira de lidar com os fatos científicos pode mudar (e já mudou). A forma tecnológica de ver o mundo através do satélite, mesmo quando a Amazônia está realmente sendo destruída, pode ser alterada para fechar os olhos à realidade.

REFERÊNCIAS

AMOORE, L. (2020). Cloud Ethics: Algorithms and the Attributes of Ourselves and Others. Duke University Press.

BERGER, J. (2008). Ways of Seeing. Penguin UK.

BLAS, Z. (2011). Facial weaponization suite. https://zachblas.info/works/facial-weaponization-suite/

CRARY, J. (1992). Techniques of the Observer. MIT Press.

CRAWFORD, K., & Paglen, T. (2019). Excavating AI: The politics of training sets for machine learning. Retrieved from https://anatomyof.ai/

HARAWAY, D. (1988). Situated knowledges: The science question

in Feminism and the privilege of partial perspective. Feminist Studies, 14(3), 575. https://doi.org/10.2307/3178066

HARVEY, A. (2020). Building Archives for Evidence and Collective Resistance. Presented at Transmediale 2020, Berlin.

IMPETT, L. (2020). Early Modern Computer Vision. Presented at The Renaissance Society of America, Philadelphia. https://rsa.confex.com/rsa/2020/meetingapp.cgi/Paper/4424

KASTRENAKES, J. (2018). Salesforce employees ask CEO to ‘re-

-examine’ contract with border protection agency – The Verge. Retrieved 2020-08-07 from https://www.theverge.com/2018/6/25/ 17504154/salesforce-employee-letter-border-protection-ice-immigration-cbp

LI, F.-F. (2015). How we’re teaching computers to understand pictures. Retrieved 2020-08-07 from https://www.ted.com/talks/fei_fei_li_how_we_re_teaching_computers_to_understand_pictures

MACKENZIE, A. (2013). Programming subjects in the regime of anticipation: Software studies and subjectivity. Subjectivity, 6(4), 391-405. https://doi.org/10.1057/sub.2013.12

MATISSE, H. (1954). Looking at life with the eyes of a child. ArtReview. https://artreview.com/archive-matisse-looking-at-life-with-the-eyes-of-a-child-1954/

MCFARLAND, E. (2019). Watch the watcher: Facial-recognition & police oversight. Retrieved 2020-08-07 from https://www.youtube.com/watch?v=f0xwvXHqPbU

MONTEIRO, M., & Rajão, R. (2017). Scientists as citizens and knowers in the detection of deforestation in the Amazon. Social Studies of Science, 47(4), 466-484. https://journals.sagepub.com/doi/pdf/10.1177/0306312716679746

NUNES, P. (2019). Levantamento revela que 90,5% dos presos por monitoramento facial no Brasil são negros – The Intercept Brasil. Retrieved 2020-08-07 from https://theintercept.com/2019/11/21/presos-monitoramento-facial-brasil-negros/

OpenOversight. Retrieved 2020-08-07 from https://openoversight.lucyparsonslabs.com/

PARKS, L. (2005). Cultures in Orbit. Duke University Press.

PEREIRA, G., Moreschi, B. (2020). Artificial intelligence and institutional critique 2.0: Unexpected ways of seeing with Computer Vision. AI & Society.

VRAME: Computer Vision Tools For Human Rights Researchers. Retrieved 2020-08-07 from https://vframe.io/

VURDUBAKIS, T., & Rajão, R. (2020). Envisioning Amazonia: Geospatial technology, legality and the (dis)enchantments of infrastructure. Environment and Planning E: Nature and Space, 2514848619899788. https://journals.sagepub.com/doi/pdf/10.1177/2514848619899788

WEST, S. M. (2017). Data capitalism: Redefining the logics of surveillance and privacy. Business & Society, 58(1), 20-41. https://doi.org/10.1177/0007650317718185